najpopularniejsze artykuły

linux unix proftpd nginx php rtorrent rutorrent mysql ssl startssl

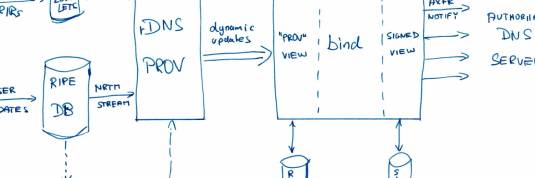

Podstawowe zabezpieczenie serwera dns - BIND

Skanując wiele serwerów dns w sieci można znaleźć wiele nieprawidłowo skonfigurowanych, pełniących rolę tzw. "openDNS",czyli odpowiadających na zapytanie o dowolną domenę. Na domiar złego wiele…

ProFTPD - serwer ftp na Linuxa (wirtualni użytkownicy)

Proftpd jest jednym z najpopularniejszych serwerów ftp dla Linuxa. Łatwy w konfiguracji, dość powiedzieć, że od razu po instalacji można z niego korzystać. UWAGA:Po zainstalowaniu…

Darmowe certyfikaty SSL od StartSSL

Chcąc przesyłać jakiekolwiek dane zawierające poufne informacje (m.in loginy i hasła), zawsze powinniśmy wykorzystywać szyfrowane połączenie. Dzięki temu unikniemy sytuacji, w której dane zostaną odczytane…

Grub2 - szybkie dodawanie systemu windows

Do napisania tego tekstu skłoniły mnie problemy podczas ostatniej instalacji systemu a raczej problem z tzw. bootloadrem. Odkąd zacząłem korzystać z Linuxa przeważnie korzystałem z…

Fail2Ban - blokowanie ataków brute force

Fail2Ban jest aplikacją, która powinna być zainstalowana w zasadzie na każdej maszynie działającej pod kontrolą Unix / Linux / BSD, wystawioną na świat (zewnętrzne IP).…

Okresowa zmiana hasła

Wstęp W dobie ostatnich doniesień o wycieku danych takich hegemonów internetu jak: Dropbox, LinkedIn czy Yahoo dobrą praktyką wydaje się wymusić na użytkownikach regularną zmianę…